数据与问题分析

问题介绍

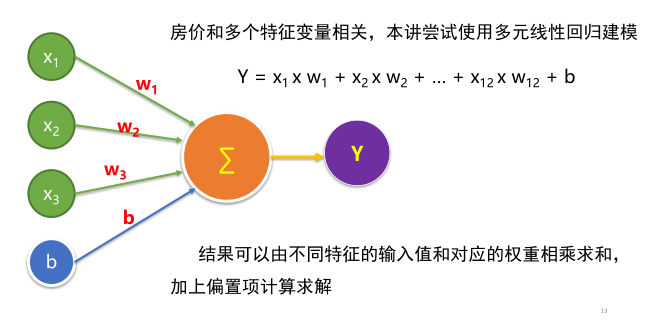

波士顿房价数据集包括506个样本,每个样本包括12个特征变量和该地区的平均房价

房价(单价)显然和多个特征变量相关,不是单变量线性回归(一元线性回归)问题

选择多个特征变量来建立线性方程,这就是多变量线性回归(多元线性回归)问题

采用上一节所讲:机器学习步骤

数据集解读

CRIM: 城镇人均犯罪率

ZN:住宅用地超过 25000 sq.ft. 的比例

INDUS: 城镇非零售商用土地的比例

CHAS: 边界是河流为1,否则0

NOX: 一氧化氮浓度

RM: 住宅平均房间数

AGE: 1940年之前建成的自用房屋比例

DIS:到波士顿5个中心区域的加权距离

RAD: 辐射性公路的靠近指数

TAX: 每10000美元的全值财产税率

PTRATIO: 城镇师生比例

LSTAT: 人口中地位低下者的比例

MEDV: 自住房的平均房价,单位:千美元

读取数据1

2

3

4

5

6

7

8

9

10

11

12

13

%matplotlib notebook

import tensorflow as tf

import matplotlib.pyplot as plt

import numpy as np

import pandas as pd

from sklearn.utils import shuffle

df = pd.read_csv("boston.csv",header=0)

print(df.describe())

(想快速读取常规大小的数据文件时,通过创建读缓存区和其他的机制可能会造成额外的开销。此时建议采用Pandas库来处理。)

准备建模

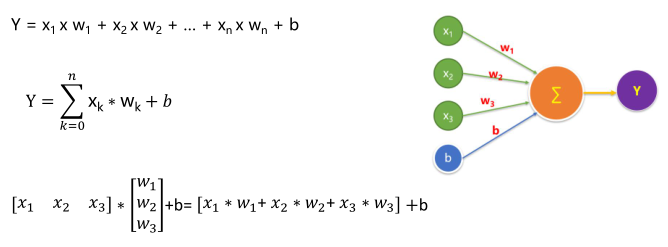

采用多元线性回归模型

多变量线性方程的矩阵运算表示

第一个版本的模型构建

数据准备

1 |

|

构建模型

定义训练数据占位符

shape中 None 表示行的数量未知,在实际训练时决定一次代入多少行样本,从一个样本的随机SDG到批量SDG都可以

定义模型结构

定义命名空间

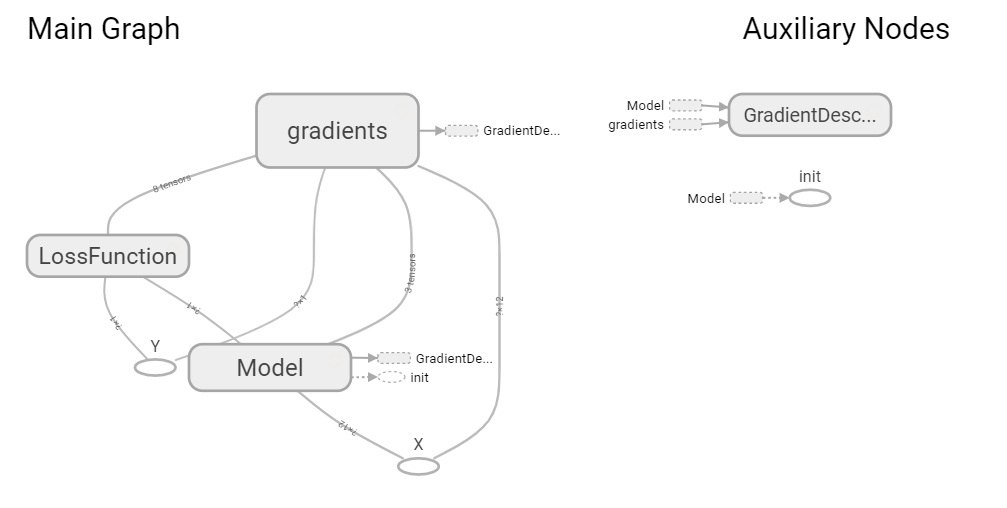

Tensorflow计算图模型中常有数以千计节点,在可视化过程中很难一下子全部展示出来,因此可用name_scope为变量划分范围,在可视化中,这表示在计算图中的一个层级。

训练模型

设置训练超参数

定义均方差损失函数

声明会话/启动会话

迭代训练1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

x = tf.placeholder(tf.float32,[None,12],name = "X")

y = tf.placeholder(tf.float32,[None,1],name = "Y")

with tf.name_scope("Model"):

w = tf.Variable(tf.random_normal([12,1],stddev=0.01),name="W")

b = tf.Variable(1.0,name="b")

def model(x, w, b):

return tf.matmul(x, w) + b

pred = model(x, w, b)

train_epochs = 50

learning_rate = 0.01

with tf.name_scope("LossFunction"):

loss_function = tf.reduce_mean(tf.pow(y-pred,2))

optimizer = tf.train.GradientDescentOptimizer(learning_rate).minimize(loss_function)

sess = tf.Session()

init = tf.global_variables_initializer()

sess.run(init)

for epoch in range (train_epochs):

loss_sum = 0.0

for xs, ys in zip(x_data, y_data):

xs = xs.reshape(1,12)

ys = ys.reshape(1,1)

_,loss = sess.run([optimizer,loss_function],feed_dict = {x:xs,y:ys})

loss_sum = loss_sum + loss

x_data,ydata = shuffle(x_data, y_data)

b0temp = b.eval(session=sess)

w0temp = w.eval(session=sess)

loss_average = loss_sum/len(y_data)

print("epoch=",epoch+1,"loss=",loss_average,"b=",b0temp,"w=",w0temp)

运行结果出现异常!!

探究训练结果异常的原因:从梯度下降讲起

二元两个变量(或多变量)要比一元单变量复杂得多,要考虑不同特征值取值范围大小的影响

采用方法:归一化

( 特征值- 特征值 最小值)/ ( 特征值最大值- 特征值最小值)

后续版本的持续改进

特征数据归一化

1 |

|

模型应用1

2

3

4

5

6

7

8

9

10

11

n = 348

x_test = x_data[n]

x_test = x_test.reshape(1,12)

predict = sess.run(pred, feed_dict={x:x_test})

print("预测值:%f" % predict)

target = y_data[n]

print("标签值:%f" % target)

可视化训练过程中的损失值

1 | loss_list = [] |

可视化损失值1

plt.plot(loss_list)

加上TensorBoard可视化代码

为可视化准备数据1

2

3

4

5

6

7

logdir = 'e:/log'

sum_loss_op = tf.summary.scalar("loss",loss_function)

merged = tf.summary.merge_all()

创建摘要的文件写入器

1 | writer = tf.summary.FileWriter(logdir,sess.graph) |

添加代码

1 | _,summary_str,loss = sess.run([optimizer,sum_loss_op,loss_function],feed_dict={x:xs,y:ys}) |